歷經三年疫情,Computex 2023 的首場大會演講,迎來了最近當紅的產業搖滾巨星-Nvidia 創辦人暨執行長黃仁勳,甚至吸引台塑董事長王文淵率領旗下大將與會聽講。

不同於前一天在台大畢業典禮的演講,在屬於舒適圈的科技主場大會上,將近兩小時的演講中,黃仁勳沒有看稿、沒有停頓或卡詞,保持高度的熱情,向現場約 3,500 名觀眾解釋未來的運算樣貌。

本文目錄

未來萬物皆 AI 運算進入 2.0 時代

首先,黃仁勳表示過去 40 年來,CPU 每 5 年增加 10 倍算力的摩爾定律時代已經過去了。過去 CPU 的「通用運算」架構讓電腦具備足以寫出各種程式的靈活彈性,但進入 AI 時代之後,通用運算架構已經不足以應付這種大規模的運算需求。

因此,黃仁勳提出「加速運算」的概念,推翻掉通用運算的概念,重新設計底層的晶圓到高階的作業系統、演算法、應用程式等等,建立足以實現能水平連接擴充算力的伺服器與資料中心,滿足 AI 需要大量算力訓練模型及平行運算的需求。

「加速運算是跨領域的概念,不同的產業需要建立自己的演算法、資料集與模型,」黃仁勳表示:「通用運算的效能成長表現無法滿足需求,唯有以 GPU 為何新的加速運算才能實現數百倍加速的效能成長。」

黃仁勳以建立大型語言模型 (LLM) 為例,以 CPU 建立運算叢集大約需要 960 台 CPU 伺服器,每小時吃電 11 Gigawatt,耗費約 1,000 萬美金。

然而同樣是花費 1,000 萬美金,你可以買到 48 台 GPU 伺服器,每小時吃電 3.2 Gigawatt,得到的效能足以建立 44 個 LLM 。

黃仁勳舉出不同的例子,強調以 GPU 伺服器建立的資料中心,在 AI 運算方面具備獨特的優勢。例如在同樣的功耗下,GPU 伺服器的效能可以達到 CPU 伺服器的 150 倍。若以同樣訓練一個大型語言模性的需求來看,只需要兩台 GPU 伺服器,功耗每小時 0.13 GW,總花費 40 萬美金即可。

「買得愈多,省得愈多」黃仁勳這樣說道,甚至開玩笑說台灣人喜歡這一味。

加速運算實現

當企業試著使用或自建產生式 AI 時,要將整個資料中心視為一台電腦,GPU 伺服器的運算架構與資料傳輸通道,決定了整個資料中心的算力表現。

過去 5 年,Nvidia 透過加速運算與人工智慧,將電腦繪圖效能提升上千倍,預計在 10 年內將達到上百萬倍的效能成長。

該如何達到如此驚人的效能成長?黃仁勳宣布推出名為 Grace Hopper 的超級晶片,是世界上第一款能夠 CPU 和 GPU 之間共享 600GB 記憶體的加速運算處理器,避免了不必要的資料複製,進而提高了運算效能。 Grace Hopper 搭載了大容量高速的 DDR 和 LPDDR 記憶體,適用於高可靠性資料中心應用。

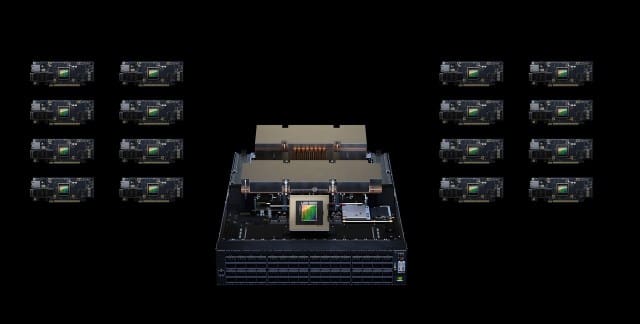

然後再使用 NVIDIA NVLink 網路技術,將 256 個 NVIDIA Grace Hopper 超級晶片,以每秒 900GB 的速度連接成一個資料中心大小的 GPU Server-DGX GH200,達到 1 exaflop 的算力,表現比一台 NVIDIA DGX A100 320GB 系統高出近 500 倍。這使得開發人員可以用它來開發用於生成式人工智慧聊天機器人的大型語言模型、用於推薦系統的複雜演算法,以及用於偵測詐欺及資料分析的繪圖神經網路。

NVIDIA 同樣在打造自家的大型人工智慧超級電腦 NVIDIA Helios,預計將於今年上線。它將使用 NVIDIA Quantum-2 InfiniBand 網路技術來連結四套 DGX GH200 系統,提供最高每秒 400GB 的頻寬,以強化訓練大型人工智慧模型所需的資料處理能力。

模組化伺服器架構與網路交換平台

面對不同的使用情景,企業需要各種配置的 GPU 伺服器。 Nvidia 也推出了名為 NVIDIA MGX 的模組化參考架構,讓系統製造商能夠以成本效益的方式快速開發出超過百種不同配置的伺服器,以滿足各種人工智慧、高效能運算和 NVIDIA Omniverse 應用程式的需求。

NVIDIA MGX 採用通用架構和模組化的零組件,可以在各種氣冷式和液冷式機箱中使用。它支援 NVIDIA 全線 GPU 、 CPU 、資料處理單元 (DPU) 和網路卡,同時也支援 x86 和 Arm 架構的處理器。

在八月份,雲達科技和美超微將成為首批推出採用 NVIDIA MGX 設計的機型的公司。美超微在 COMPUTEX 展會上宣布推出的 ARS-221GL-NR 系統將搭載 Grace CPU,而雲達科技在同一場展會上宣布推出的 S74G-2U 系統則將使用 Grace Hopper 超級晶片。

此外,永擎電子、華碩、技嘉和和碩聯合科技也將採用 NVIDIA MGX 來開發下一代的加速運算電腦。

除了伺服器以外,資料中心的網路交換平台也是運算效能關鍵之處。宣布了一項名為 NVIDIA Spectrum-X 的新網路平台,專為提高乙太網路架構下人工智慧雲端環境的效能和效率而設計。這個平台整合了 Spectrum-4 乙太網路交換器、 BlueField-3 DPU(資料處理單元)和相應的軟體,能夠將人工智慧運算效能提升 1.7 倍,同時提高電源使用效率。

多家知名系統建造商已經採用了 NVIDIA Spectrum-X 、 Spectrum-4 交換器和 BlueField-3 DPU,包括 Dell Technologies 、聯想和美超微等公司。這些合作夥伴將能夠在他們的產品中充分發揮 NVIDIA 的先進網路技術,提供更高效的人工智慧運算解決方案。