立訊精密疑似遭勒索軟體RansomHub攻擊,資料外洩威脅公開蘋果等客戶機密。駭客宣稱取得立訊多項機密資訊,若不支付贖金將洩露數據,對公司及其客戶可能造成重大災難。

〈NVIDIA〉彙整頁面 - 網路資訊雜誌

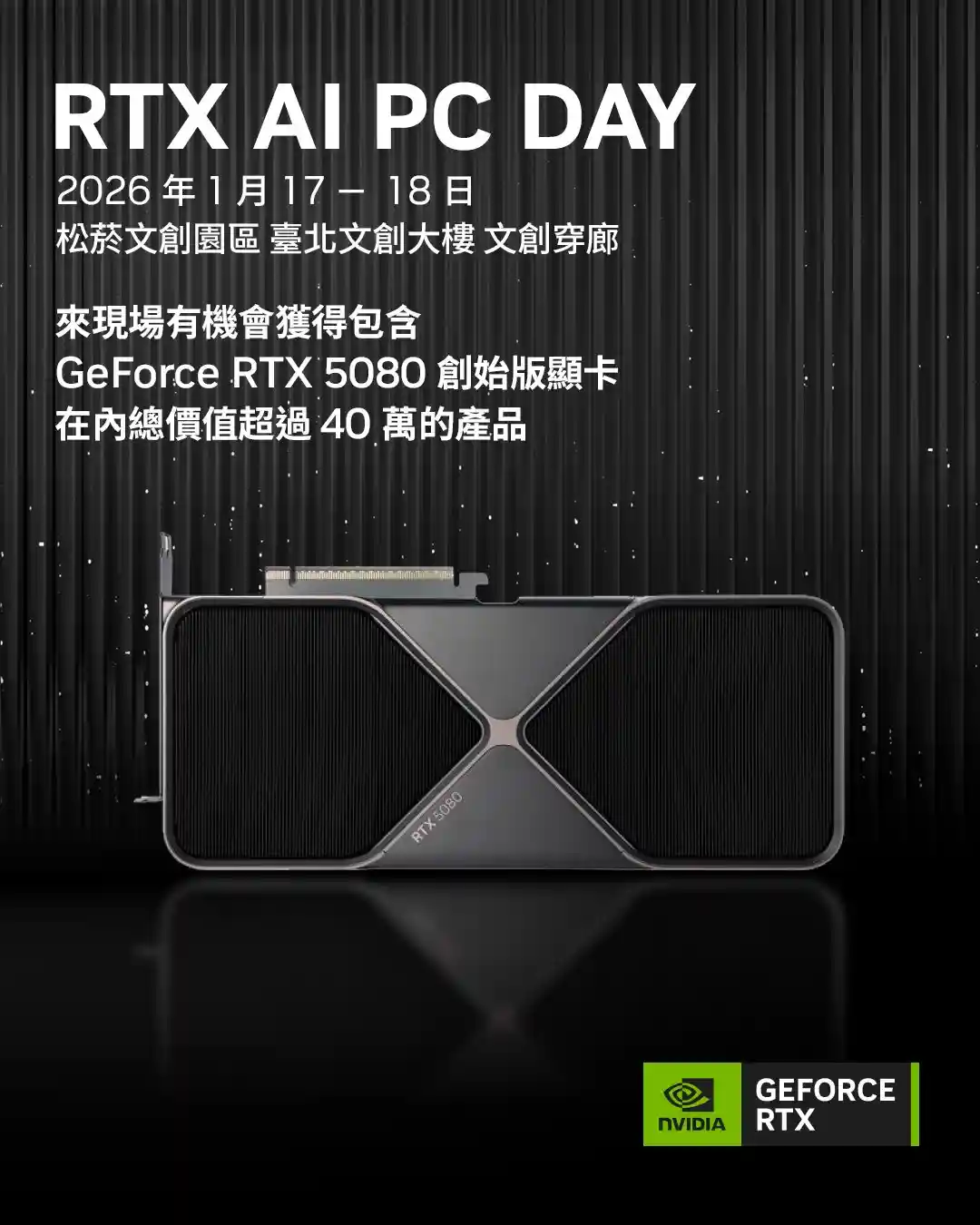

RTX AI全面進化的時代正式來臨!NVIDIA RTX AI PC DAY於松菸盛大登場,集結最新GeForce RTX 50系列桌機與筆電,結合實機體驗、人氣KOL互動、AI主題講座與超過40萬元豪禮抽獎,帶領玩家、創作者與專業工作者一次感受RTX AI在遊戲、創作與生產力上的無限可能。

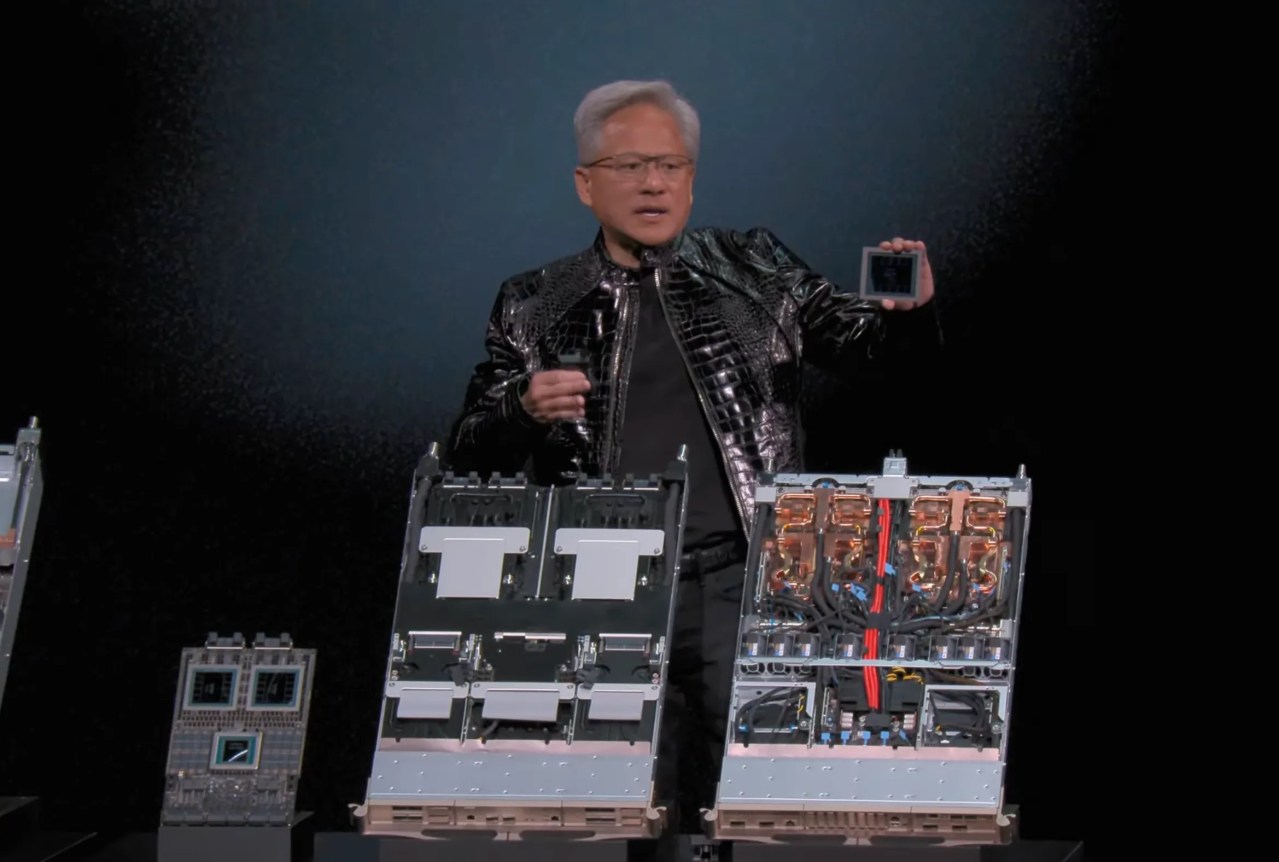

Nvidia在CES展示了Vera Rubin GPU架構,性能提升顯著,推論效能快5倍、訓練效能快3.5倍、記憶體頻寬增長2.8倍。儘管競爭激烈,AMD也推出Helio機櫃,Nvidia計畫提前上市,鞏固其在AI運算平台的優勢。

NetApp發布AFX儲存系統與AIDE引擎,結合NVIDIA架構解決企業資料孤島痛點,加速代理式AI應用落地;並聯手資策會導入後量子密碼技術(PQC),強化資料防護最後防線,全面提升台灣產業資安韌性。

Nvidia在NeurIPS會議上推出全球首個開原自駕車推理視覺語言模型Alpamayo-R1(AR1),結合思維鏈推理與路徑規劃。同時,還發布多個數位AI模型與工具,強化其在自駕車、機器人及語音處理的領先地位。

Nvidia發布軟體更新修補Isaac-GR00T平台的兩個高風險漏洞,編號CVE-2022-33183和CVE-2025-33184,風險值達7.8,可能遭本地攻擊者濫用,導致未授權程式碼執行及資料竄改。建議用戶儘速更新。

NVIDIA在最新MLPerf Training v5.1中橫掃七大基準測試,展現Blackwell Ultra架構的強大訓練效能,從大型語言模型到圖像生成全面刷新紀錄,加速推動AI運算的下一波突破。

雙11購物熱潮來襲,NVIDIA攜手各大品牌夥伴推出GeForce RTX 50系列筆記型電腦限時優惠活動,GeForce RTX 50筆電最高折9, 000,GeForce RTX 50系列主機最高省13, 991。搭載Blackwell架構的次世代AI筆電,為學生、玩家、創作者、專業工作者等帶來年度最佳升級契機。

Nvidia 宣布其新款桌面 AI 工作站 DGX Spark 開始出貨,售價 4000 美元,具備 128GB 記憶體和 1 petaflop 算力,可跑大型LLM。預計可滿足 AI 開發需求,並挑戰雲端服務的市場優勢。

Nvidia投資英特爾50億美元,雙方將合作開發整合Nvidia GPU與Intel CPU的多代資料中心及PC晶片,強化對抗AMD的競爭力,並推進AI及加速運算領域合作。

自 1990 年創刊 UXmaster 雜誌,1991 年獲得美國 LAN Magazine 獨家授權中文版,2006 年獲得 CMP Network Computing 授權,2009 年合併 CMP Network Magazine 獨家授權中文版,2014 年轉型為《網路資訊》雜誌網站,為台灣中小企業協助技術領導者落實企業策略,了解網路規劃及應用,為企業網路應用、管理、 MIS 、 IT 人員必備之專業雜誌網站。

© Copyright 2025 本站版權所有,禁止任意轉載 網路資訊雜誌 / 心動傳媒股份有限公司 聯絡電話:+886 2 29432416