Red Hat 在 2025 年 Summit 大會上推出多項 AI 佈局與資安功能,包括「llm-d 開原專案」用於大規模分散式推論,以及專為邊緣小型模型打造的 RamaLama 推論方案。 Red Hat 亞太區技術長 Vincent Caldeira 來台針對今年大會進一步說明相關技術細節。

本文目錄

llm-d 分散式推論專案:強化 GPU 利用率

Red Hat 本次發表的 llm-d(又稱 llm-d)專案,結合 Kubernetes 技術與 vLLM 推論引擎,旨在實現跨多 GPU 叢集的分散式推論。透過智慧地將推論請求路由至適當的加速器,llm-d 可大幅提高現有 GPU 基礎設施的利用率,例如將單機僅 20% 的利用率提升至 80–100% 。 Red Hat 執行長 Chris Wright 比喻,這就像是將早期 Linux 上的伺服器運算與 Kubernetes 的分散部署作法,延伸應用到 AI 推論層面。

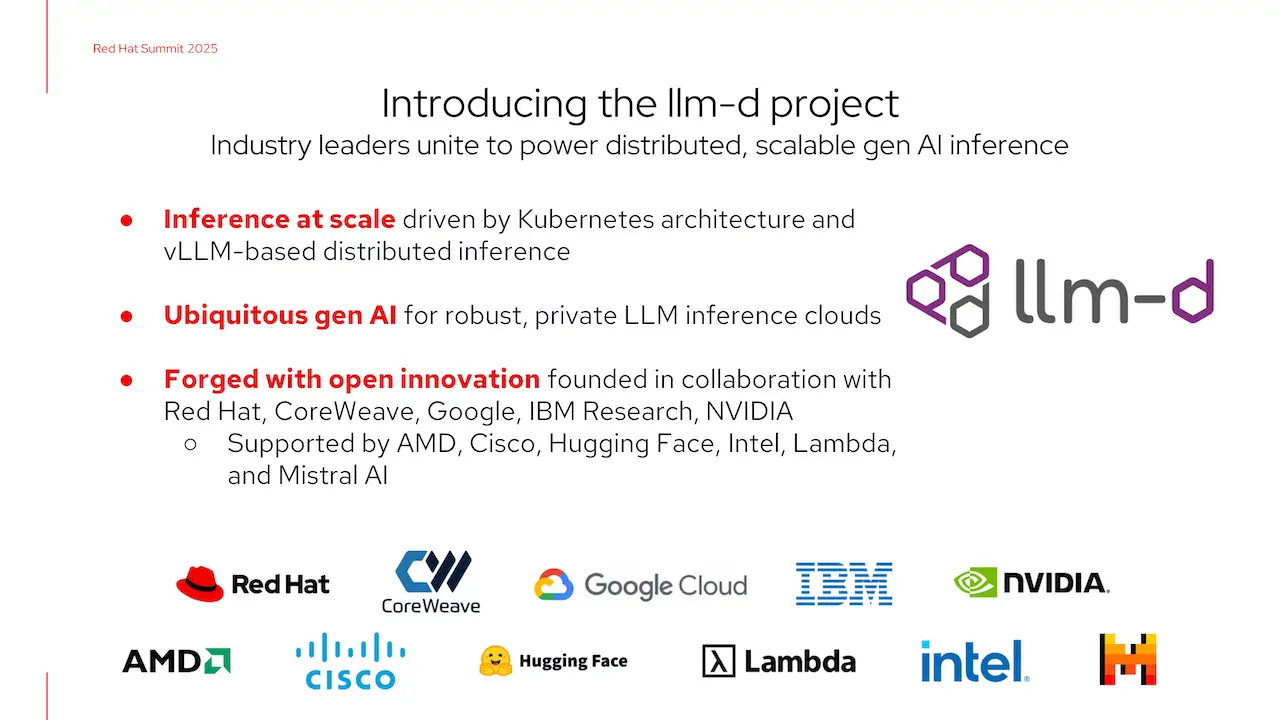

此外,llm-d 開原社群在推出之初即獲得產業廣泛響應,包括 CoreWeave 、 Google Cloud 、 IBM Research 、 NVIDIA 等加入為創始貢獻者,AMD 、 Cisco 、 Hugging Face 、 Intel 、 Lambda 、 Mistral AI 等廠商也列為合作夥伴。這些合作關係將使 llm-d 在硬體和模型領域都能持續優化,助力企業在混合雲中大規模佈署 AI 推論工作負載。

RamaLama 小模型推論方案:邊緣裝置的輕量化推理

針對參數較少、適合在邊緣或本地裝置上執行的輕量級模型,Red Hat 推出了 RamaLama 方案。 RamaLama 利用開原的 llama.cpp 推論引擎,將其容器化並與 Red Hat Enterprise Linux (RHEL) 整合,使開發者能輕鬆在個人電腦或微型伺服器上本地運行 Llama 類模型。

RamaLama 會優先嘗試使用用戶本機已安裝的推論引擎(如 llama.cpp),以充分發揮 GPU 加速效能,也可以在需要時執行容器內模型。 Red Hat 開發團隊表示,此方案可快速部署到各種環境,降低複雜度,例如可在自動駕駛、製造業等場景的頭節點裝置上運行,支援即時且資源敏感的 AI 服務。

產業合作與模型壓縮:與 Google 、 Meta 、 Neural Magic 共拓生態

Red Hat 同場宣布擴大與業界巨頭的合作。在 Google Cloud 聯盟下,Red Hat 與 Google 共同啟動了 llm-d 開原計畫,Google Cloud 成為創始貢獻者之一,並將為其 TPU 與 GPU 平台提供 vLLM 支援,未來 Red Hat AI 推論伺服器將整合至 Google Cloud 環境。與此同時,Red Hat 與 Meta 的合作也涵蓋了企業級生成式 AI;雙方承諾對 Llama 系列模型提供「Day 0」即時支援,並讓 Red Hat 平台支援 Llama Stack 應用開發。

在模型壓縮與推理效率方面,Red Hat 將剛收購的 Neural Magic 技術整合到 AI 推論伺服器中,內建高效的 LLM 壓縮工具,能在不犧牲模型精度的情況下大幅減少模型尺寸與運算需求。這些合作與技術的結合,讓企業得以「任何模型、任何加速器、任何雲端環境」都能迅速部署生成式 AI,並享有社群開原的彈性與效能優化。

開放原生 Linux 新特色:Image Mode 與 Lightspeed 助理

在企業級 Linux 平台方面,Red Hat 也推出 RHEL 10,加入多項與 AI 和安全相關的新功能。其中 Image Mode(映像模式)將 RHEL 作業系統打包成可開機容器映像,以容器化思維提供更一致穩健的部署方式;而嶄新的 RHEL Lightspeed AI 助手則直接整合於命令列界面,利用自然語言介面提供情境感知的操作建議,協助系統管理員從故障排除到腳本撰寫都能更高效。這些功能結合了 AI 能力與未來量子抗性的安全機制(包括先進的後量子加密),讓 RHEL 10 成為混合雲與 AI 時代下一代作業系統的基石。

AI 資安挑戰:資料污染與非決定性風險

除了功能創新,Red Hat 也提醒企業注意生成式 AI 帶來的資安新威脅。專家指出,AI 系統的主要攻擊向量往往在於訓練數據本身,攻擊者可透過在訓練集中注入惡意或篡改數據(Data Poisoning),使模型產生偏差甚至產生漏洞。另一個挑戰在於生成式 AI 的結果往往具有非決定性(non-deterministic)性質,同樣的輸入可能得出不同的輸出,這會使傳統的安全驗證與異常偵測更加困難。因此,Red Hat 強調企業在導入 AI 解決方案時,應同步強化資料供應鏈管理和模型安全防護,並建立跨部門的風險評估與管理機制,以確保生成式 AI 應用的可靠度與安全性。