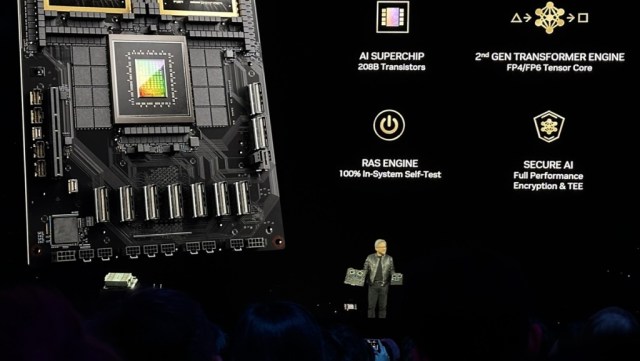

Nvidia 周二在 GTC 2024 大會上發表全新 Blackwell GPU 架構。集結 6 項創新技術,可將運算速度大幅提升。

Nvidia 號稱它能支援高達一兆參數的的大型語言模型,同時又比採用 Grace Hopper 架構的現有 H100 GPU 成本與功耗降低 25 倍。

Nvidia 表示,Blackwell 將可實現資料運算、工程模擬、電子設計自動化、電腦輔助藥物設計及量子運算。 Blackwell 架構之名來自美國知名統計學及數學家 David Harold Blackwell,他的研究對博奕理論、概率理論、資訊理論和統計學貢獻卓著。

本文目錄

支援超大 AI 模型的 Blackwell 架構

Blackwell 植基的新技術包含客製化的 4 奈米製程晶片,其次是 Nvidia 第二代 Transformer Engine,可為 Nvidia TensorTT-LLM 及 NeMo Megatron 框架加入微張量 (micro-tensor) 擴充能力及動態範圍管理演算法,能支援更大的運算演算法及更大型的 AI 模型。

Blackwell 晶片內含第 5 代 NVLink 網路交換功能,每顆 GPU 可提供最高每秒 1.8 terabits,一個節點可提升 576 顆 GPU 的通訊速度,比前代晶片更能有效支援複雜的 LLM 運行。此外,它也包含了新的 RAS Engine,是第一顆專為穩定性 (reliability) 、可用性 (availability) 和可服務性 (serviceability) 而設計的晶片。晶片層也加入新能力以支援 AI 預防性維運功能,像是更強的診斷能力及穩定性。

這些新增功能將能提高系統營運時間,使大型 AI 系統得以一直無礙運行數月。此外,Blackwell 也加入了機密運算能力,以防護 AI 模型及資料安全,可滿足醫療和金融服務客戶的需求。新的解壓縮技術 Decompression Engine 可加速 AI 模型、資料分析和資料科學家的資料庫查詢。

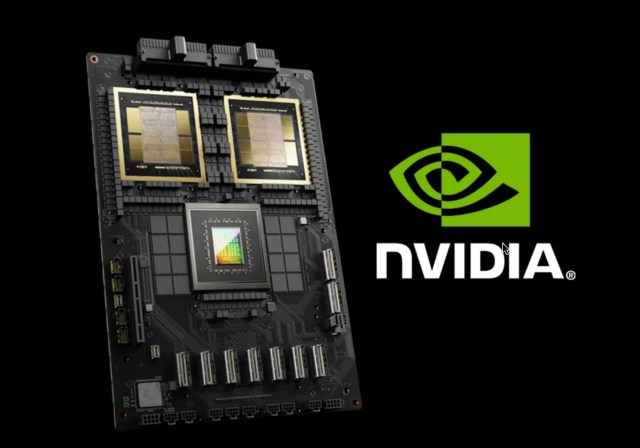

同時推出 GB200 Grace Blackwell Superchip

Nvidia 同時也宣佈了新 GB200 Grace Blackwell Superchip,包含 2 顆 Nvidia B200 Tensor Core GPU 以及 Nvidia Grace CPU,連同 900 gigabit/s 的超省電 NVLink 互連技術。

GB200 Grace Blackwell Superchip 還有最新的 Quantum-X800 InfiniBand,後者是第一個傳輸率抵達 800 gigabit/s 的網路平台,可串聯更多 GPU,推升 AI 和其他高效能運算的效能。 Nvidia 指出,GB200 Grace Blackwell Superchip 是新一代 Nvidia SuperPOD DGX GB2000 NVL72 平台的核心元件,這個平台是專為高運算負載的多節點液冷式機架規模系統,包含最多 36 顆 GB200 Grace Blackwell Superchip,包括 72 顆 Blackwell GPU 、 36 顆 Grace CPU,及 BlueField-3 DPU,可實現 1.4 exaflops AI 效能及 30TB 記憶體。 Nvidia 指出,這效能是現有 H100 Tensor Core GPU 架構的 30 倍。

最新的 Nvidia SuperPOD DGX 預計今年稍晚推出,但客戶有多種購買選擇。在 GTC 大會上,Nvidia 表示,除了 Nvidia 自己的 DGX Cloud 平台外,Amazon Web Services 、 Google Cloud 和微軟 Azure 平台都會提供 Blackwell GPU 方案。其他採用的雲端平台還包括 Ooredoo Hutchinson 、 Nexgen Cloud 、 Oracle EU 主權雲、以及 Oracle 美、英及澳洲政府雲。

客戶也可以買搭載 Blackwell GPU 的資料中心伺服器,供應商包括 Dell 、 HPE 、 Lenovo 、 Cisco 及 Super Micro,他們今年稍晚就會推出第一套 Blackwell GPU 伺服器方案。